iOS 26:機械学習によるレンズ汚れ検知「レンズクリーニングヒント」が利用可能

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、WWDC25において、Appleプラットフォームで利用可能なVisionフレームワークの最新アップデートを紹介する「Visionフレームワークによるドキュメントの読み込み」を公開しています。

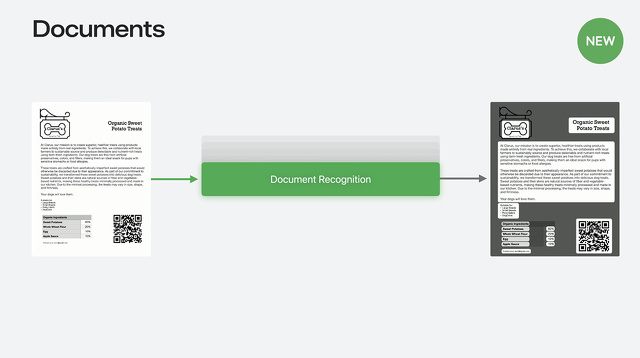

Visionに追加されたAPIとして、Visionではテキスト認識が向上していて、ただテキストを読むのではなくドキュメントを認識します。

26言語のテキストを認識し、様々なドキュメント構造がグループ化され、ドキュメントの処理と認識が容易になります。

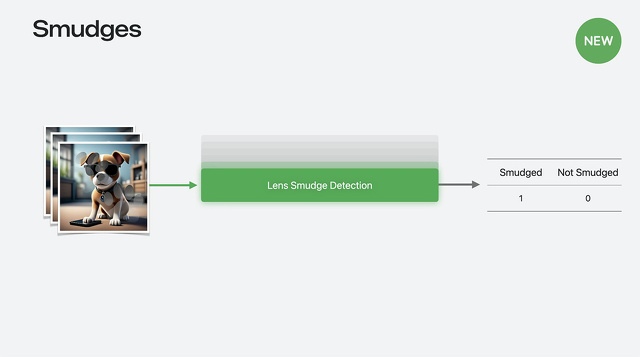

Visionには新しいレンズの汚れを検出モード「DetectLensSmudgeRequest」があり、カメラレンズの汚れを検出し、 画像の乱れを防ぎます。

画像が汚れたレンズで撮影されたかどうかを識別し、ユーザーにレンズのクリーニングや別の写真の提供を促すことができます。このリクエストを利用することで、アプリで高品質な画像のみを処理することが可能になります。

DetectLensSmudgeRequest は、Vision Framework の他のリクエストと同様に機能します。

このリクエストを画像に対して実行すると、汚れの観測データが生成され、この観測データには、画像が汚れている確率を示す信頼度スコアが付与されます。

信頼度は常に 0 から 1 の範囲で、信頼度が 1 に近いほど、画像が汚れている確率が高いことを示します。

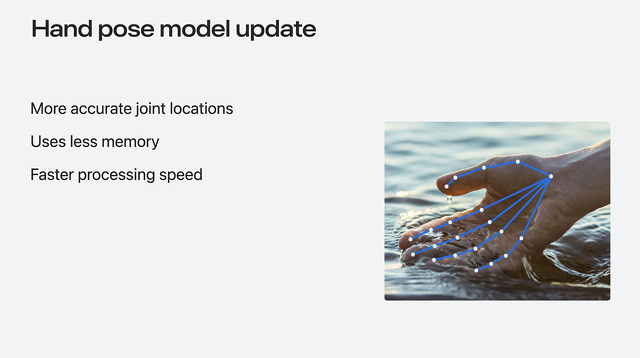

今年、Visionは、手のポーズ検出モデルをより小型で最新のモデルに置き換えます。

新しいモデルでも21個の関節を検出しますが、精度が向上し、メモリ使用量とレイテンシが削減されています。

新しいモデルの精度は向上していますが、関節の位置は以前のモデルと同じではありません。そのため、過去にMLの手のポーズ分類器またはMLの手の動作分類器をトレーニングしたことがある場合は、精度を向上させるために新しいモデルで分類器を再トレーニングすることをお勧めします。