Apple、精度と遅延のトレードオフを実現する視覚言語モデル「FastVLM」を発表

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、CVPR 2025において、テキスト入力に加え、視覚的な理解を可能にする視覚言語モデル(VLM)に関して、シンプルな設計で精度とレイテンシのトレードオフを大幅に改善する新しいタイプのVLM「FastVLM」を発表しています。

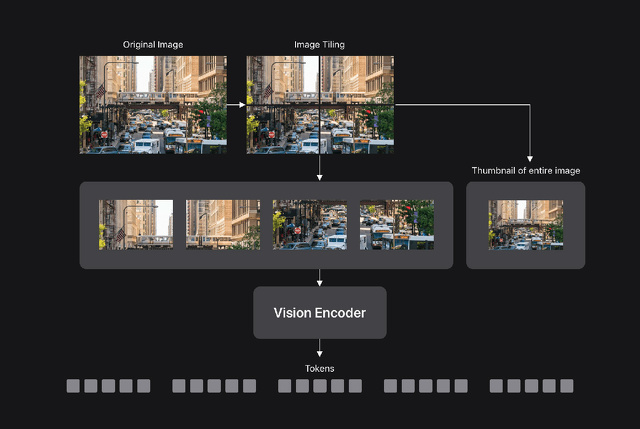

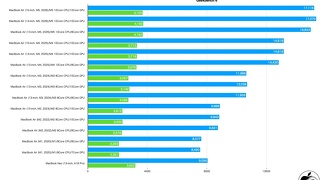

高解像度画像向けに設計されたハイブリッドアーキテクチャのビジュアルエンコーダーを活用したFastVLMは、正確で高速かつ効率的なビジュアルクエリ処理を実現し、デバイス上で動作するリアルタイムアプリケーションの開発に適しています。

VLMは、視覚的理解とテキスト理解を組み合わせることで、様々な有用なアプリケーションを実現できます。これらのモデルの精度は一般的に入力画像の解像度に対応するため、精度と効率性の間でパフォーマンスのトレードオフが生じることが多く、高い精度と優れた効率性の両方が求められるアプリケーションではVLMの価値が限られていました。

FastVLMは、高解像度画像向けに構築されたハイブリッドアーキテクチャのビジョンエンコーダであるFastViTHDを活用することで、このトレードオフに対処します。シンプルな設計により、FastVLMは精度と効率の両方において従来のアプローチを凌駕し、リアルタイムのデバイス内アプリケーションに適したデバイス内ビジュアルクエリ処理を実現します。