argmax、Apple GPUやNeural Engineに最適化した音声認識AI「WhisperKit」を発表

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

argmaxが、 高い精度で文字起こしができる音声認識AIを、GPUやNeural Engineに最適化した「WhisperKit」を発表しています。

OpenAIの「Whisper」は低遅延でオーディオを処理するように設計されていないため、リアルタイム速度でのストリーミング文字起こしは非常に困難です。

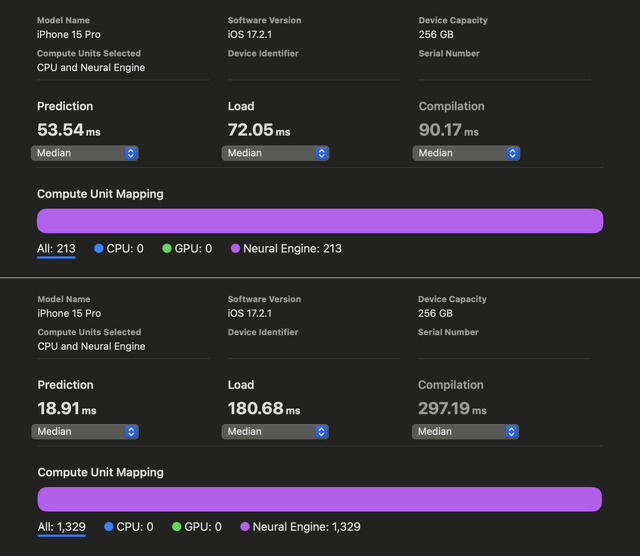

WhisperKitは、Appleシリコン上で最低のレイテンシーと 最高のスループット状態の両方を達成することを目指して開発されていて、本日のベータ リリースでは、iPhone、iPad、Mac でストリーミング文字起こしアプリケーションのロックを解除するために、最初に遅延の最小化に意図的に重点を置いたバージョンだそうです。

Swift プロトコルにモジュール化されているため、カスタム動作の実装は個々のプロトコル拡張に集約されます。また、コードの読み取り時間についても最適化されているため、WhisperKit の拡張は難しくなく、コントリビューションガイドとロードマップリソースは、機能が完成し、安定したリリース候補段階に到達するためのタイムラインを開発者に可視化することを目的としているとしています。

オーディオエンコーダは「Deploying Transformers on the Apple Neural Engine」に従って、Core ML を使用して「Whisper.cppプロジェクト」によって以前に最適化されました。簡単に言うと、この作業では、一連のNeural Engineコンパイラヒントを PyTorch コードとして導入し、Core ML に変換すると高パフォーマンスのモデルに変換されます。

Neural Engine コンパイラが Apple のプライベート フレームワークであることを考えると、これはハードウェアの使用率を高めるためにコンパイラを微調整するブラック ボックス最適化の一種です。

これは Whisper のオーディオ エンコーダを高速化するための優れた出発点であり、私たちの以前の成果がさまざまなオープンソース プロジェクトに採用されていることを嬉しく思います。

WhisperKitでは、これらのコンパイラヒントをさらに改善し、以前の最良の実装と比較して、iPhone 12 ~ 15 でさらに1.86 倍から 2.85 倍の高速化を実現したと説明しています。

Introducing WhisperKithttps://t.co/smfsWo6HLN pic.twitter.com/Xhy2mRKq6N

— argmax (@argmaxinc) January 30, 2024